一文看懂CARLA中的视觉传感器

本文从CARLA出发,深入Unreal Engine内部,带大家理解CARLA中的视觉传感器及真值系统的实现原理。得益于UE,自动驾驶测试仿真工具CARLA在图像渲染方面有着远超其他传统仿真器的画面质量。最明显的就是CARLA中一系列的视觉传感器(Camera Sensor)。

什么是传感器?

传感器是连接外界环境和被测车辆的媒介。传感器使汽车自动驾驶能够感知其环境,从而发现并分类障碍物,预测速度,协助精准定位车辆周围的环境。

从仿真角度来讲,无论是哪种传感器,理论上都可以从以下三个不同层级进行仿真。第一个层级是对物理信号进行仿真,第二个层级是对原始信号进行仿真,第三个层级是对传感器目标进行仿真。

传感器的发展推动了智能技术和自动化系统的进步,对于提高生活质量,生产效率以及安全性具有重要意义。

CARLA自带语义分割传感器实现路径

从UE层面理解Camera

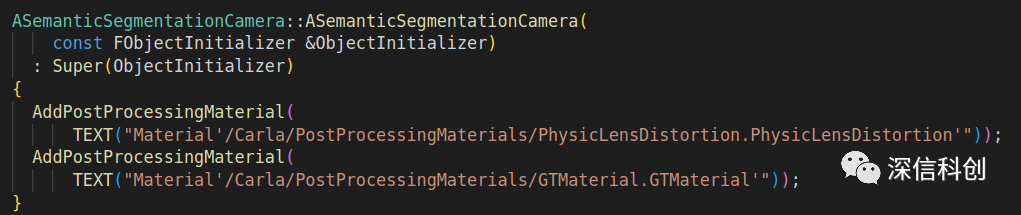

后处理材质都放在哪:从代码中去看,拿语义分割Camera举例。该传感器用了两个后处理材质:物理畸变模型、GroundTruth标注,使用文件搜索关键词,能搜索到在文件夹中的位置。

语义视觉传感器初始化时添加后处理材质图

语义视觉传感器初始化时添加后处理材质图  后处理材质文件图

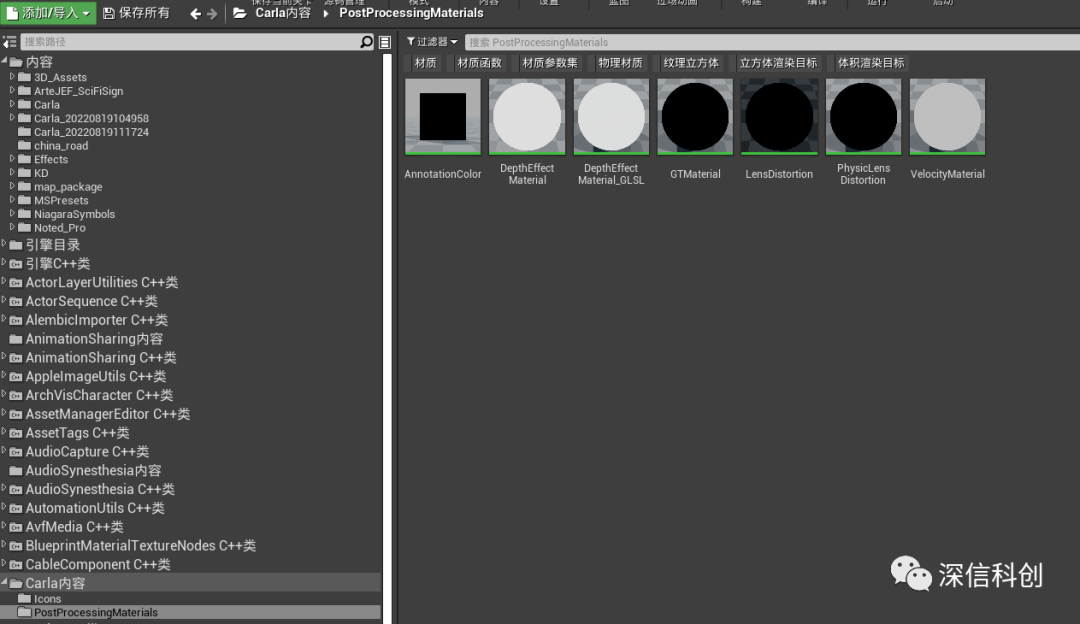

后处理材质文件图

CARLA插件内容文件夹路径图

CARLA插件内容文件夹路径图

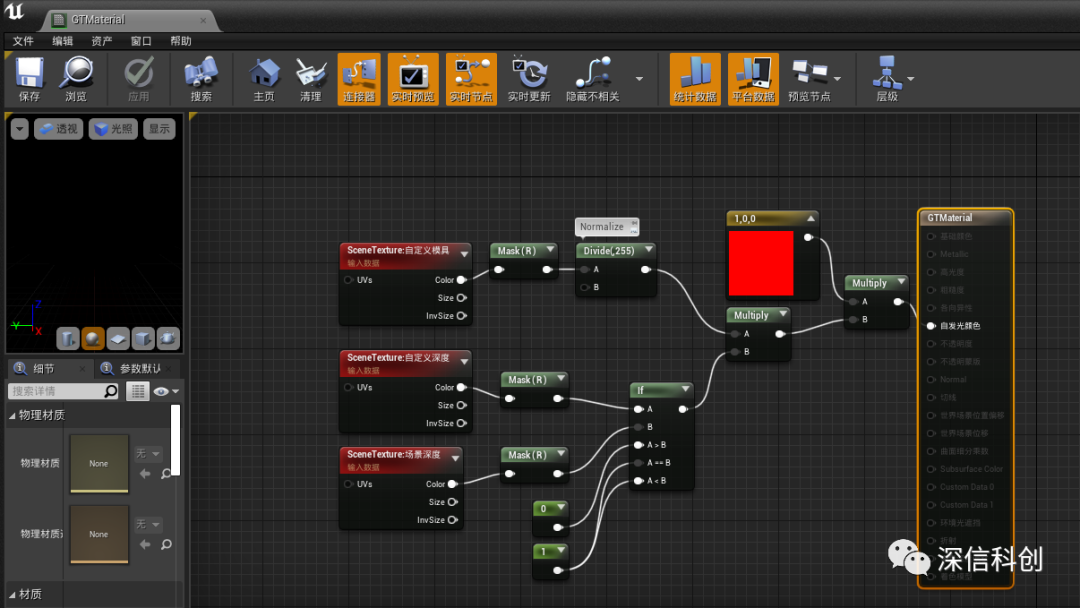

点开后可以看到该材质文件的蓝图逻辑:

深度视觉传感器后处理材质蓝图

深度视觉传感器后处理材质蓝图

语义分割的实现原理

语义分割的后处理材质蓝图:

语义分割的后处理材质蓝图

路面Mesh自定义深度模具值图

路面Mesh自定义深度模具值图  车道线Mesh自定义深度模具值图

车道线Mesh自定义深度模具值图 登录后免费查看全文

著作权归作者所有,欢迎分享,未经许可,不得转载

首次发布时间:2024-02-25

最近编辑:8月前

还没有评论

相关推荐

最新文章

热门文章