Ansys EBU产品GPU推荐配置指导(23R1)

GPU推荐配置指导(2023R1版本)

1.电子桌面GPU推荐概要

GPU支持包括Quadro和Tesla卡以及GPU代(Kepler (K), Maxwell (M), Pascal (P), Volta (V), Turing/RTX,Ampere(A))。GPU加速已经为英伟达卡开发,并得到Tesla系列的官方支持。当在一台机器上使用多个卡并行解决多个变化(DSO)或激励(HPC)时,强烈建议NVIDIATesla卡获得最佳性能。

HFSS频域和时域解算器支持Ampere系列的NVIDIA数据中心GPU以及Volta、Pascal和Kepler系列的Tesla GPU。除Quadro GV100外,不支持所有代的NVIDIAWorkstation RTX和Quadro GPU。

HFSS SBR+解算器支持Ampere系列的NVIDIA数据中心GPU以及Volta、Pascal、Maxwell和Kepler系列的Tesla GPU。HFSS SBR+解算器支持RTX和Quadro系列的NVIDIA工作站GPU。

Maxwell解算器支持Ampere系列的NVIDIA数据中心GPU以及Volta、Pascal和Kepler系列的Tesla GPU。除Quadro GV100外,不支持所有代的NVIDIA Workstation RTX和Quadro GPU。

Ansys EMIT支持Ampere系列的NVIDIA数据中心GPU以及Volta、Pascal、Maxwell和Kepler系列的Tesla GPU。EMIT支持RTX和Quadro系列的NVIDIA工作站GPU。

Icepak支持NVIDIA的支持CUDA的Tesla和Quadro系列工作站和服务器卡。

2.ANSYS产品与对应的N卡系列

AVxcelerate 支持 NVIDIA 支持 CUDA 的系列工作站和服务器卡。

Ansys EMIT 和 EMIT Classic 支持支持 NVIDIA CUDA 的工作站、数据中心和服务器卡。

Fluent 支持 NVIDIA 支持 CUDA 的工作站、数据中心和服务器卡。

HFSS 频域和时域求解器支持支持 NVIDIA CUDA 的工作站、数据中心和服务器卡。

HFSS SBR+ 求解器支持支持 NVIDIA CUDA 的工作站、数据中心和服务器卡。

ICEPAK 支持 NVIDIA 支持 CUDA 的工作站、数据中心和服务器卡。

Maxwell 求解器支持支持 NVIDIA CUDA 的工作站、数据中心和服务器卡。

Mechanical APDL 支持 AMD Instinct MI 系列加速器和 NVIDIA 支持 CUDA 的工作站、数据中心和服务器卡。当使用带有 NVIDIA 卡的稀疏求解器或基于稀疏求解器的特征求解器时,需要额外考虑(请参阅 ANSYS 安装指南了解详细信息)。

Polyflow 支持 NVIDIA 支持 CUDA 的工作站、数据中心和服务器卡

3.HPC激活细则

必须了解的GPU相关的概念

Pascal架构是NVIDIA推出的第一代GPU架构,于2016年发布。它采用了16nm工艺,提高了能源效率,支持多重GPU操作,适用于游戏和工作站的不同应用领域。Pascal架构是NVIDIA发展历程中的重大里程碑,并为后来的架构奠定了基础。

Volta架构是NVIDIA于2017年推出的专为AI计算和高性能计算而设计的GPU架构。它采用超过20亿个晶体管,具有更高的能源效率,具备16位精度、32位精度和64位精度的混合精度,使其深度学习功能得到了全面升级,同时可以胜任大规模科学计算任务。它为人工智能和科学计算提供了更好的性能和运算能力。

Turing架构是NVIDIA于2018年推出的GPU架构,主要支持实时光线追踪(RTX)功能,以及人工智能、深度学习等新的应用场景。Turing架构包括RT Core用于加速实时光线追踪,Tensor Core用于加速深度学习计算,并且支持新型的VR(Virtual Reality)渲染技术。

Ampere架构是NVIDIA于2020年推出的新一代GPU架构,它专为AI和高性能计算而设计,采用了8nm工艺和第三代Tensor Core,使其在深度学习和大规模计算任务中具备更高的性能和效率,同时提供HPC(High Performance Computing)和安全方面的新功能,如Multi-Instance GPU和分区加密等。Ampere架构的出现在计算领域中具有里程碑意义,代表着未来计算的新方向。

总之,架构越先进,算力也就强悍。

显卡SM与CUDA的关系

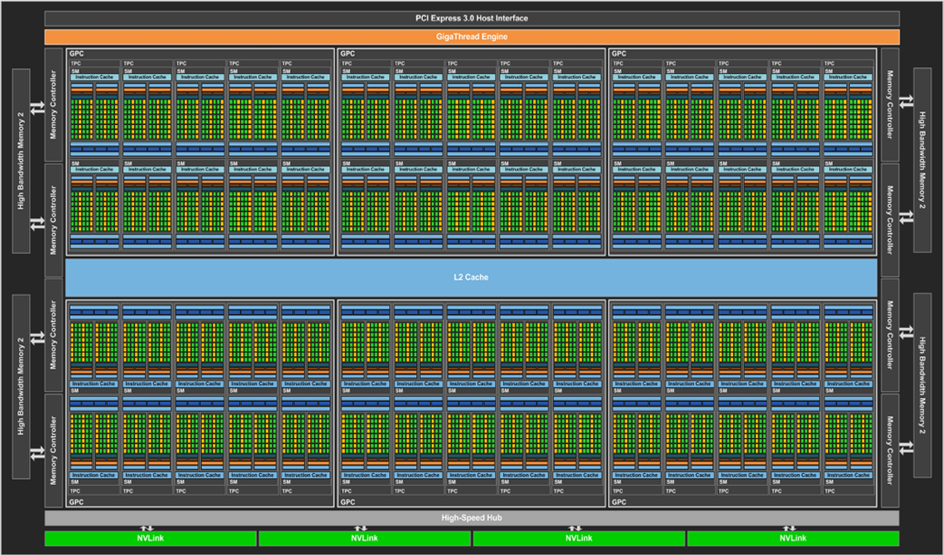

StreamingMultiprocessor (SM)

下面这个图是SM:

SM和CUDA之间的关系是SM是支持CUDA的基本硬件单元。CUDA程序由大量的线程组成,每个线程都需要在SM上执行。SM可以同时执行多个线程,每个线程需要的资源由SM动态分配和管理。而CUDA框架则提供了一系列API和库,使程序员可以在GPU上编写并行计算程序。

因此,显卡中的SM和CUDA是紧密相关的,SM是支持CUDA的基本硬件单元,CUDA则是一种在SM上进行并行计算的框架和编程模型。CUDA使得程序员可以充分利用SM的并行能力,实现高效率的并行计算。

算力与SM的关系

显卡的算力是指其能够进行浮点运算的速度,通常使用的衡量标准是FLOPS(浮点运算每秒数)。显卡的算力与SM(Streaming Multiprocessor,流式处理器)的数量和性能密切相关。每个SM都是一组专用浮点单位,可以执行各种计算,包括矩阵乘法、卷积、池化等等。

不同型号的显卡拥有不同数量和性能的SM。例如,NVIDIA的GTX 1080 Ti有28个SM,每个SM有128个可编程CUDA核心,总共有3584个CUDA核心,可以提供11.3 TFLOPS的单精度浮点性能。而Tesla V100拥有80个SM,每个SM有64个CUDA核心,总共拥有5120个CUDA核心,可以提供15.7 TFLOPS的单精度浮点性能。

因此,显卡的算力通常与SM的数量和性能密切相关,而SM的数量和性能又取决于显卡的型号和制造商。

SM 与HPC Packs的关系

# SM’s | HPC Workgroups | HPC Packs |

1 – 40 | 0 | 0 |

41 – 48 | 1 – 8 | 1 |

49 – 72 | 9 – 32 | 2 |

73 – 168 | 33 – 128 | 3 |

169 – 552 | 129 – 512 | 4 |

553 – 2088 | 513 – 2048 | 5 |

备注:使用多个 GPU 时,许可基于所有 GPU 上的 SM 总数,与 GPU 数量无关

软件设置与HPC Packs

Electronics products

1 个 HPC Pack 通过可用的 12 个 HPC 任务支持多达 12 个 CPU 内核 + 1 个 GPUs

2 个 HPC Packs 通过可用的 36 个 HPC 任务支持多达 36 个 CPU 内核 + 4 个 GPUs

3 个 HPC Packs 通过可用的 132个 HPC 任务支持多达 132 个 CPU 内核 + 16 个 GPUs

举例说明

客户装有GV100显卡,查找手册知道,SM=80,最多可以使用3个HPC Packs,

具体设置如下:

Electronicsproducts:

3 个 HPC Packs 通过可用的 132个 HPC 任务支持多达 132 个 CPU 内核 + 16 个 GPUs

Fluids* /Structural products:

3 个 HPC Packs 通过可用的 132个 HPC 任务支持多达 66 个 CPU 内核 + 66个 GPUs

4.相关环境配置

驱动配置要求

NVIDIA GPU最低驱动程序要求由NVIDIA CUDA版本决定。当前的Ansys EM使用CUDA 10.2,该版本要求Windows x86_64的最低驱动程序版本为441.22,Linux x86_64最低驱动程序版为440.33。

建议为用户特定的卡下载标准NVIDIA驱动程序,而不是在Windows操作系统上下载“DCH”驱动程序。

散热配置

服务器需要主动冷却的风扇,也可以如英伟达Tesla K80的带有GPU冷却解决方案(被动冷却)的服务器。

为了获得最佳性能,用于运行模拟作业的GPU不应连接到任何显示器。只能使用CUDA计算兼容性3.0(开普勒)及以上版本的GPU卡。为了提高瞬态场可视化的速度,应该在带有PCI-E 3.0插槽的系统上安装GPU卡。混合使用PCI-E版本较低的接口卡可能会导致数据无法以最高速度从GPU传输到CPU。