新论文:结构响应行为预测的深度学习模型有N种,该怎么选?

论文链接:https://doi.org/10.1177/13694332231184322

太长不看版

目前,已经有大量学者提出了可用于结构(构件/材料)响应时程预测的深度学习模型。为了给该领域内神经网络模型的选择提供参考,并开展网络架构进一步优化,本研究开展了以下工作:

建立并开源了不同尺度的数据集,针对部分典型神经网络模型进行了案例分析与比较;

针对门控循环网络(LSTM/GRU)和注意力机制网络(Transformer等)的长、短期记忆能力进行了分析与解释;

提出了两项通用、易执行的网络架构优化方法:(a) 多层次shortcut和(b)带权重的特征融合机制。

数据、模型与程序开源

本研究的基础数据集(以及课题组整理的其他一些相关数据、相应的说明文档)可以从下面的链接处下载。本研究提出的网络架构的示例性代码也附在同一链接中。

https://github.com/XYJ0904/Weighted-Pyramid-Stacked-Network

如有任何意见或建议,欢迎通过文末的联系方式向作者提出。

01 研究背景

基于深度神经网络构建结构(构件/材料等也可,下同)响应行为的代理模型,近年来得到很多研究者的关注。此类方法具有拟合能力强、端到端(无需人为干预中间过程)、可以取得“精度-效率”的良好平衡等优点。在诸多相关研究中,如何选取合适的网络架构已然成为一个焦点问题。此外,既有神经网络普遍采用基于单一层次特征的预测模式或等权重的特征融合机制,这不利于神经网络把握受历史行为高度影响的复杂响应特征。为了解决上述问题,本研究开展了网络比选、不同架构能力分析、架构优化等系列工作。

02 数据集构建

本研究共采用了结构、构件和材料三个尺度的8个特征不同的数据集,以开展更为全面、深入的对比,如图1和表1所示。

案例1-2:带阻尼的3层框架层模型(MRFDBF案例)、基于BoucWen滞回关系的层模型(BoucWen案例)响应行为数据集

案例3-4:基于支撑的精细有限元模型模拟得到的响应行为数据集(构建正则化&未正则化的两个数据集)(案例Huang-N和Huang)

案例5-8:不同特征的Giuffré-Menegotto-Pinto材料(OpenSees steel 02)的滞回行为数据集(案例OP-1至OP-4)

图1 研究案例示意图

表1 研究案例基本信息概述

03 架构选取与对比结果

本研究选取几种典型网络架构,包括很早提出但仍然常见的Multi Layer Perception(MLP)(亦称Fully Connected Network(FCN)或者Artificial Neural Network(ANN)),门控循环架构的代表Long Short-term Memory Neural Network(LSTM),适用于时程学习的卷积神经网络的代表One-Dimensional Convolutional Neural Network(1D-CNN),强化局部关联性的Recursive LSTM(Rec-LSTM),基于注意力机制的典型网络架构Transformer(Trans),融合物理机制和神经网络的PhyCNN,以及融合门控架构和注意力机制的Unrolled Attention Sequence-to-Sequence(UA)网络。

基于上述八个不同的数据集,本研究开展了网络训练、验证与测试,得到结果如图2所示。其中,纵轴为Normalized Loss,含义为“将每个案例中表现最差的网络的Loss调整为1.0”后的损失函数相对值。可以看出,在参与对比的网络架构中,UA网络表现最佳,LSTM其次,而MLP网络表现最差。

图2 八个数据集上各个网络Normalized Loss平均值(PhyCNN结果详见论文)

表2 测试集MSE(绝对值)

04 长、短期记忆能力试验与分析

相较LSTM网络,UA网络在门控机制的基础上引入了注意力机制,并取得了更好的总体表现。然而,在部分案例上(OP-2和OP-3),LSTM网络的表现更优。在其他学者的研究中,在“引入了注意力机制后网络表现是否提升”这一问题上,得到的结论也有所不同(详见论文)。这为网络架构的选取带来了挑战。

本文分析认为,LSTM网络采用门控机制(GRU类似),隐式的考虑各个时间步之间的关联性,具有良好的短期记忆能力。但由于梯度消失等因素难以克服,因此长期记忆能力不佳。而以注意力机制为基础的网络,基于注意力运算显式的关联各个历史时间步,因此具有良好的全局(长期)记忆能力。但由于注意力值的长尾分布等特性,可能导致短期记忆能力较LSTM差。

为验证上述分析,本研究设计了一个“记忆试验”。该试验中,输入为长2000步的时间序列,而输出则为输入序列的拷贝,但向后推移了D个时间步,如图3所示。本研究中,建立了15个不同的数据集,分别取D为10、20、30、40、50、60、70、80、90、100、200、500、1000、1500和1900。每个数据集均包含1000条随机起点的样本(700训练,200验证,100测试)。

图3 记忆试验中的输入、输出示意图

随后,本研究基于LSTM网络和以注意力机制为基础的Transformer网络,开展了网络训练与测试,得到如图4所示的结果。可以看出,Transformer网络在不同间隔D的情况下,表现变化幅度不大。但当D ≤ 50时,LSTM网络的性能优于Transformer数个数量级;而当D ≥ 60时,结论完全相反。需要指出,研究过程中多次调整了网络的超参数(如隐藏层维度、层数、初始学习率等),但并不会改变上述结论。

图4 不同间隔D下的网络测试表现

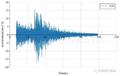

进一步的,选取D = 50和D = 60两种情况下的关键案例进行分析(如图5所示),可以看出,D = 50时LSTM网络近乎完美的复 制了输入序列,而D = 60时则几乎遗忘了所有信息(预测结果几乎恒为0)。

图5 LSTM网络在两个临界数据集上的典型预测案例

05 网络架构优化:Pyramid Networks

经典网络架构的最终预测与输出层普遍仅接受最近一个隐藏层的特征,并据此开展预测。而多个层次特征融合,在计算机视觉等领域已经被证实是一种行之有效的性能优化方法。因此,本研究提出了在基础架构中添加多层次shortcut的方法,以将不同层次的特征纳入网络的输出层,实现网络性能优化。

图6 融合多层次shortcut的网络架构示意图(以优化后的Transformer为例)

同时,在设计合理的神经网络中,越深层次的特征与输出的关联性应当越密切,等权重的对待各层次特征并不合理。因此,本研究提出了一个带权重的特征融合机制,按照特征所对应的隐藏层的深度赋予特征不同的权重,进而优化网络性能。

图7 带权重的特征融合机制

引入了多层次shortcut和带权重的特征融合机制的网络被称为Pyramid Networks。需要指出,该架构优化可以在多种基础架构上适用(如LSTM/GRU、Transformer、UA网络等),是通用、易执行的。在前述8个数据集上,本研究开展了权重选择的优化以及网络架构的比选(详见论文)。随后,开展了Pyramid Networks和其基础网络架构的对比与验证,如表3所示。可以看出,在87.5%的案例上,优化后的Pyramid Networks都取得了更好的表现。从图8-10则可以看出,网络预测结果与真实值吻合良好。

表3 Pyramid Networks与基础网络架构的测试集MSE对比

图8 Pyramid-LSTM典型预测案例

图9 Pyramid-Transformer典型预测案例

图10 Pyramid-GA典型预测案例

06 结论

本研究选取了8个不同的尺度的数据集,针对部分典型模型进行了分析比较。在参与比选的网络架构中,UA网络表现最佳,LSTM和Transformer网络其次,MLP网络表现最差。同时,本研究开展了LSTM网络和Transformer的长短期记忆能力对比,证明LSTM网络具有良好的短期记忆能力,而Transformer等注意力机制网络具有良好的全局(长期)记忆能力。此外,本研究还提出了多层次shortcut和带权重的特征融合机制两项通用、易执行的网络架构优化方法。案例分析证明,在不同的基础架构上,上述优化方法均有利于提升模型表现。

联系我们

如您有任何意见或建议,欢迎联系:

徐永嘉 博士 xuyongjia0904@163.com

---End---