GPU加速Fluent计算

本文摘要(由AI生成):

文章主要介绍了如何使用Fluent软件在GPU上进行计算,包括设置并行计算的核数和GPU数量,使用命令行打开显卡计算并进行设置,以及一些精度和求解方法的设置。需要注意的是,有的模型本身有限制,无法使用并行加速方法。文章还提到,如果使用自编代码进行三维模型计算,会麻烦很多,但后续会更新相关内容。

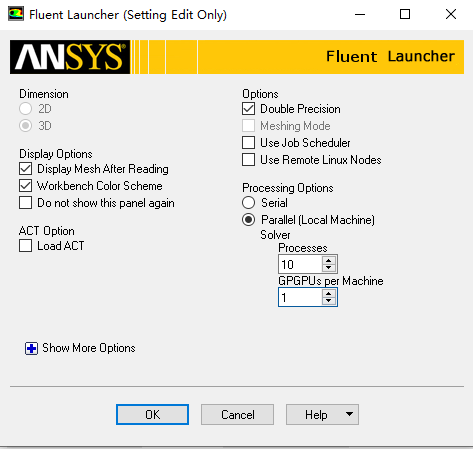

用Fluent开启GPU进行计算,过程其实很简单,不过现在只找到采用N卡进行计算的方法。首先在开始界面需要设置并行计算的核数与你要用来计算的GPU数量,一般电脑都只有一块显卡,所以设置为1就可以了。

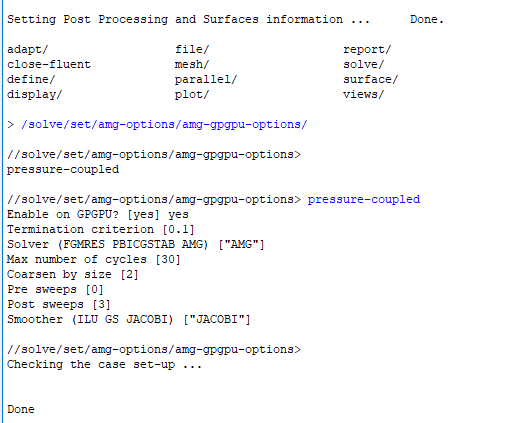

打开之后就需要用命令行去打打开显卡计算并进行设置,命令行/solve/set/amg-options/amg-gpgpu-options/,后面还需要跟上你想并行计算的模型比如我这里的压力耦合计算,后面是一些精度和求解方法的设置,其中精度和迭代次数比较重要,搞得不好反倒会发散,比如这里设置为0.1,如果过大那时间就会比较长。

设置好了之后运行就可以了,也没什么需要注意的,但是有的模型本身就有限制用不了并行加速方法,具体的可以参考这里的内容https://www.nvidia.cn/data-center/gpu-accelerated-applications/ansys-fluent/

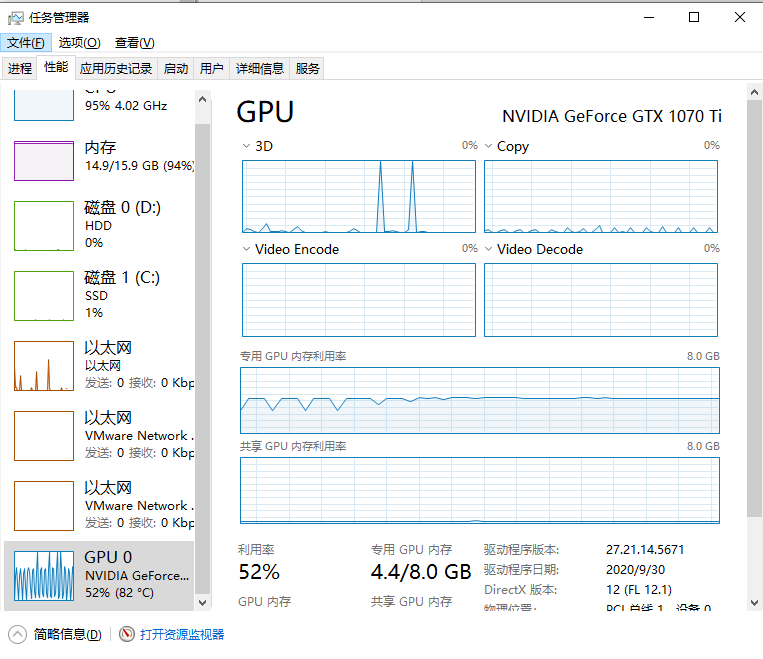

我这里模型比较小,计算时间就2分钟效果提升不明显,大的模型会明显一些,但显卡确实用起来了。

如果是自己编写的程序想并行求解的会麻烦很多,但也不是没有办法。后续更新如何用自编代码进行三维模型计算,包括读取网格(基于Openfoam格式的网格),处理拓扑,离散求解一系列流程。

登录后免费查看全文

著作权归作者所有,欢迎分享,未经许可,不得转载

首次发布时间:2021-07-15

最近编辑:7月前

还没有评论

相关推荐

最新文章